Mistral AI, la pépite française de l’intelligence artificielle, vient de lancer Mistral Medium 3.1, un nouveau modèle pensé pour les entreprises. Alliant performance, confidentialité et flexibilité, il peut être déployé en local sur des serveurs internes ou dans un cloud privé. Une approche qui le distingue des grands acteurs américains.

Un modèle pensé pour la souveraineté numérique

Avec Medium 3.1, Mistral AI poursuit sa stratégie de proposer des solutions d’IA adaptées aux besoins des entreprises européennes. Contrairement à la majorité des modèles disponibles uniquement dans le cloud public, Medium 3.1 offre la possibilité d’être hébergé en interne, garantissant ainsi une meilleure maîtrise des données. Cette approche répond à une préoccupation croissante : la souveraineté numérique.

Des performances comparables aux géants de l’IA

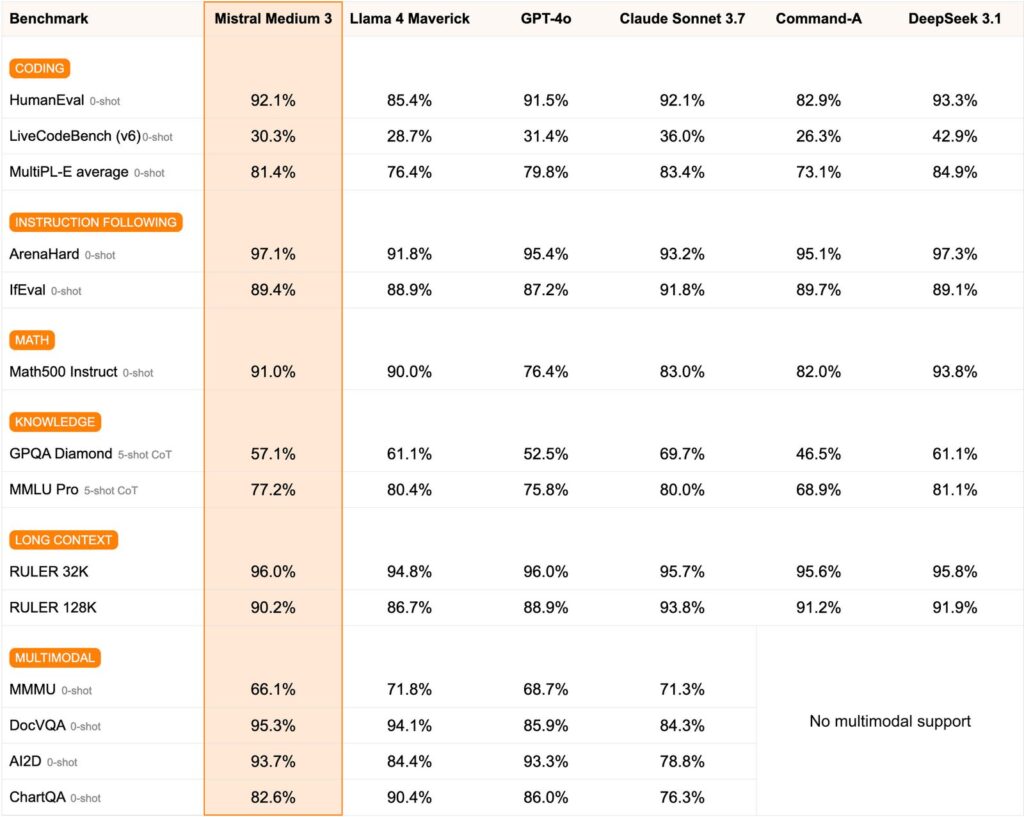

Medium 3.1 se positionne comme un modèle de classe frontier, capable de rivaliser avec les références du marché. Selon les benchmarks publiés, il excelle en raisonnement logique, multimodalité et génération de code.

Face à des concurrents comme Claude Sonnet 3.7 ou Llama 4 Maverick, le modèle de Mistral s’impose par sa précision et son coût compétitif : environ 0,40 $ par million de tokens en entrée et 2 $ en sortie, soit jusqu’à 8 fois moins cher que certains modèles américains.

Une flexibilité inédite pour les entreprises

La grande force de Mistral Medium 3.1 réside dans sa flexibilité de déploiement. Les entreprises peuvent choisir de l’intégrer :

- en mode on-premise pour un contrôle total,

- dans un cloud privé ou hybride,

- ou via des environnements VPC pour plus de sécurité.

Ce positionnement unique fait de Mistral AI un acteur à part, répondant aux besoins des organisations qui recherchent à la fois confidentialité, personnalisation et performance.

Tester Mistral Medium 3.1 en local : les prérequis

Avant de déployer Mistral Medium 3.1 dans une infrastructure d’entreprise, il est possible de tester le modèle sur un poste de travail. Cela permet d’évaluer ses capacités et sa pertinence avant une intégration à grande échelle. Voici les prérequis essentiels :

- Système d’exploitation : Linux (Ubuntu recommandé) ou macOS. Windows est possible via WSL2.

- Matériel :

- GPU NVIDIA récent (série RTX 30xx ou supérieur) avec au moins 16 Go de VRAM,

- CPU multicœurs (8 cœurs recommandés),

- 32 Go de RAM système minimum.

- Stockage : prévoir au moins 50 Go d’espace libre pour le modèle et les dépendances.

- Pilotes et frameworks :

- Connexion internet : nécessaire pour télécharger le modèle depuis Hugging Face ou le portail de Mistral AI.

Une fois ces prérequis installés vous pouvez lancer une simple commande (via ollama run mistral-medium) ou un script Python basé sur transformers pour commencer à interagir avec le modèle en local.

Une alternative européenne crédible

Avec ce lancement, Mistral AI confirme son ambition : offrir une alternative souveraine aux solutions proposées par OpenAI, Anthropic ou Meta. Medium 3.1 ne se limite pas à la performance technique, il propose également un cadre d’utilisation plus respectueux des contraintes réglementaires européennes.

Dans un contexte où la maîtrise des données devient stratégique, ce modèle pourrait séduire de nombreux secteurs sensibles comme la santé, la finance ou l’industrie.